Sicuramente il tuo assistente AI può prenotare un appuntamento per te, ma che ne dici di una conversazione significativa? Shutterstock / Bas Nastassia

Sicuramente il tuo assistente AI può prenotare un appuntamento per te, ma che ne dici di una conversazione significativa? Shutterstock / Bas Nastassia

Google di recente svelato la sua ultima intelligenza artificiale parlante, chiamata Duplex. Il duplex suona come una persona reale, completo di pause, "umms" e "ahhs".

Il gigante della tecnologia afferma di poter parlare con le persone al telefono per fissare appuntamenti e controllare gli orari di apertura delle attività.

Nelle conversazioni registrate che sono state giocate alla presentazione di Google, ha conversato perfettamente con gli umani sul lato ricevente, che sembravano totalmente inconsapevoli di non parlare con un'altra persona.

Queste chiamate hanno lasciato il il pubblico orientato alla tecnologia alla fiera di Google boccheggia e fa il tifo. In un esempio, l'IA ha persino capito quando la persona con cui stava parlando si è confusa, ed è stata in grado di continuare a seguire la conversazione e rispondere in modo appropriato quando gli è stato detto che non era necessario effettuare una prenotazione.

L'ascesa degli assistenti AI

Se hai utilizzato uno degli assistenti vocali attualmente disponibili, ad esempio Google Home, Apple Siri o Amazon Echo, questa flessibilità potrebbe sorprenderti. Questi assistenti sono notoriamente difficile da utilizzare per qualsiasi cosa diversa dalle richieste standard come telefonare a un contatto, riprodurre un brano, fare una semplice ricerca sul Web o impostare un promemoria.

Quando parliamo con questi assistenti della generazione attuale, siamo sempre consapevoli che stiamo parlando con un'intelligenza artificiale e spesso adattiamo ciò che diciamo di conseguenza, in un modo che speriamo massimizzi le nostre possibilità di farlo funzionare.

Ma le persone che parlavano con Duplex non ne avevano idea. Esitarono, indietreggiarono, saltarono le parole e cambiarono persino i fatti durante una frase. Il duplex non ha perso un colpo. Sembrava davvero capire cosa stesse succedendo.

Leggi di più: Gli altoparlanti intelligenti potrebbero essere il punto di svolta per l'automazione domestica

Quindi il futuro è arrivato prima di quanto ci si aspettasse? Il mondo sta per essere pieno di assistenti di intelligenza artificiale online (e al telefono) che chiacchierano allegramente e fanno di tutto per noi? O peggio, saremo improvvisamente circondati da AI intelligenti con i loro pensieri e idee che possono o meno includere noi umani?

La risposta è un no definitivo". Per capire perché, aiuta a dare una rapida occhiata a ciò che guida un'intelligenza artificiale come questa.

Duplex: come funziona

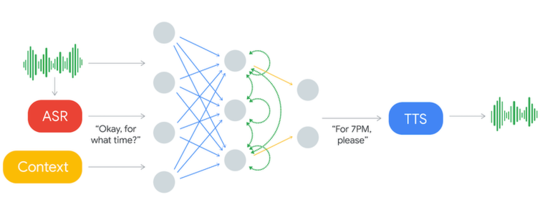

Questo è ciò che Sistema AI duplex sembra.

Il suono in ingresso viene elaborato attraverso un sistema ASR. Questo produce testo che viene analizzato con dati di contesto e altri input per produrre un testo di risposta che viene letto ad alta voce attraverso il sistema di sintesi vocale (TTS). Google

Il suono in ingresso viene elaborato attraverso un sistema ASR. Questo produce testo che viene analizzato con dati di contesto e altri input per produrre un testo di risposta che viene letto ad alta voce attraverso il sistema di sintesi vocale (TTS). Google

Il sistema accetta "input" (mostrato a sinistra) che è la voce della persona con cui sta parlando al telefono. La voce passa attraverso il riconoscimento vocale automatico (ASR) e viene convertita in testo (parole scritte). L'ASR è esso stesso un avanzato sistema di intelligenza artificiale, ma di un tipo che è già di uso comune negli assistenti vocali esistenti.

Il testo viene quindi scansionato per determinare il tipo di frase che è (come un saluto, una dichiarazione, una domanda o un'istruzione) ed estrarre qualsiasi informazione importante. Le informazioni chiave diventano quindi parte del contesto, che è un input aggiuntivo che mantiene il sistema aggiornato con quanto è stato detto finora nella conversazione.

Il testo dell'ASR e del contesto viene quindi inviato al cuore di Duplex, che è chiamato una rete neurale artificiale (ANN).

Nel diagramma sopra, la RNA è mostrata dai cerchi e dalle linee che li collegano. Le ANN sono vagamente modellate sul nostro cervello, che hanno miliardi di neuroni collegati tra loro in enormi reti.

Non proprio un cervello, ancora

Tuttavia, le RNA sono molto più semplici del nostro cervello. L'unica cosa che questa cerca di fare è abbinare le parole di input con una risposta appropriata. L'ANN apprende mostrando le trascrizioni di migliaia di conversazioni di persone che effettuano prenotazioni per ristoranti.

Con abbastanza esempi, apprende quali tipi di frasi di input aspettarsi dalla persona con cui sta parlando e quali tipi di risposte dare a ciascuno.

La risposta testuale generata dalla RNA viene quindi inviata a un sintetizzatore di sintesi vocale (TTS), che la converte in parole parlate che vengono quindi riprodotte alla persona al telefono.

Ancora una volta, questo sintetizzatore TTS è un'intelligenza artificiale avanzata - in questo caso è più avanzato di quello sul telefono, perché sembra quasi indistinguibile da qualsiasi voce normale.

Questo è tutto quello che c'è da fare. Nonostante sia all'avanguardia, il cuore del sistema è in realtà solo un processo di corrispondenza del testo. Ma potresti chiedere: se è così semplice, perché non potremmo farlo prima?

Una risposta appresa

Il fatto è che il linguaggio umano, e la maggior parte delle altre cose nel mondo reale, sono troppo variabili e disordinate per essere gestite bene dai normali computer, ma questo tipo di problema è perfetto per l'IA.

Si noti che l'output prodotto dall'intelligenza artificiale dipende interamente dalle conversazioni mostrate durante l'apprendimento.

Ciò significa che è necessario addestrare diversi IA per effettuare prenotazioni di diversi tipi, quindi, ad esempio, un'intelligenza artificiale può prenotare ristoranti e un'altra può prenotare appuntamenti per capelli.

Ciò è necessario perché i tipi di domande e risposte possono variare così tanto per diversi tipi di prenotazioni. Questo è anche il modo in cui Duplex può essere molto meglio degli assistenti vocali generali, che devono gestire molti tipi di richieste.

Quindi ora dovrebbe essere chiaro che presto non avremo conversazioni casuali con i nostri assistenti di IA. In effetti, tutti i nostri IA attuali non sono altro che i pattern matcher (in questo caso, i pattern di testo corrispondenti). Non capiscono cosa ascoltano, cosa guardano o cosa dicono.

La corrispondenza dei modelli è una cosa che fanno i nostri cervelli, ma fanno anche molto di più. La chiave per creare un'IA più potente potrebbe essere quella di sbloccare più segreti del cervello. Lo vogliamo? Beh, questo è un'altra domanda.![]()

Circa l'autore

Peter Stratton, ricercatore post-dottorato, L'Università del Queensland

Questo articolo è ripubblicato da The Conversation sotto una licenza Creative Commons. Leggi il articolo originale.