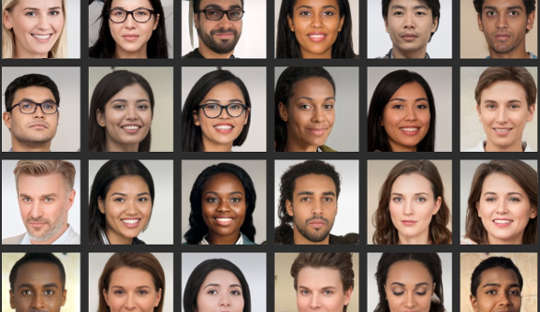

Anche se pensi di essere bravo ad analizzare i volti, la ricerca mostra molte persone non sono in grado di distinguere in modo affidabile tra foto di volti reali e immagini generate al computer. Ciò è particolarmente problematico ora che i sistemi informatici possono creare foto dall'aspetto realistico di persone che non esistono.

Di recente, un falso profilo LinkedIn con un'immagine del profilo generata dal computer ha fatto notizia perché collegato con successo con funzionari statunitensi e altri individui influenti sulla piattaforma di rete, per esempio. Gli esperti di controspionaggio affermano addirittura che le spie creano abitualmente profili fantasma con tali immagini puntare su obiettivi stranieri sui social media.

Questi falsi profondi si stanno diffondendo nella cultura quotidiana, il che significa che le persone dovrebbero essere più consapevoli di come vengono utilizzati nel marketing, nella pubblicità e nei social media. Le immagini vengono utilizzate anche per scopi dannosi, come propaganda politica, spionaggio e guerra dell'informazione.

Realizzarli implica qualcosa chiamato una rete neurale profonda, un sistema informatico che imita il modo in cui il cervello impara. Questo viene "addestrato" esponendolo a set di dati sempre più grandi di volti reali.

In effetti, due reti neurali profonde sono poste l'una contro l'altra, in competizione per produrre le immagini più realistiche. Di conseguenza, i prodotti finali sono soprannominati immagini GAN, dove GAN sta per Generative Adversarial Networks. Il processo genera nuove immagini che sono statisticamente indistinguibili dalle immagini di addestramento.

Nel nostro studio pubblicato su iScience, abbiamo dimostrato che l'incapacità di distinguere questi volti artificiali da quelli reali ha implicazioni per il nostro comportamento online. La nostra ricerca suggerisce che le immagini false possono erodere la nostra fiducia negli altri e cambiare profondamente il modo in cui comunichiamo online.

I miei colleghi e io abbiamo scoperto che le persone percepivano i volti GAN come ancora più reali delle foto autentiche dei volti delle persone reali. Anche se non è ancora chiaro il motivo, questa scoperta sì evidenziare i recenti progressi della tecnologia utilizzato per generare immagini artificiali.

E abbiamo anche trovato un collegamento interessante con l'attrattiva: i volti classificati come meno attraenti sono stati anche classificati come più reali. I volti meno attraenti potrebbero essere considerati più tipici e la faccia tipica può essere utilizzata come riferimento rispetto al quale vengono valutate tutte le facce. Pertanto, questi volti GAN sembrerebbero più reali perché sono più simili ai modelli mentali che le persone hanno costruito dalla vita di tutti i giorni.

Ma vedere questi volti artificiali come autentici può anche avere conseguenze sui livelli generali di fiducia che estendiamo a una cerchia di persone sconosciute, un concetto noto come "fiducia sociale".

Spesso leggiamo troppo nei volti che vediamo, e il le prime impressioni che formiamo guidano le nostre interazioni sociali. In un secondo esperimento che faceva parte del nostro ultimo studio, abbiamo visto che le persone erano più propense a fidarsi delle informazioni trasmesse da volti che avevano precedentemente giudicato reali, anche se erano state generate artificialmente.

Non sorprende che le persone ripongano più fiducia nei volti che credono siano reali. Ma abbiamo scoperto che la fiducia è stata erosa una volta che le persone sono state informate della potenziale presenza di volti artificiali nelle interazioni online. Hanno quindi mostrato livelli di fiducia inferiori, in generale, indipendentemente dal fatto che i volti fossero reali o meno.

Questo risultato potrebbe essere considerato utile in qualche modo, perché ha reso le persone più sospettose in un ambiente in cui possono operare utenti falsi. Da un'altra prospettiva, tuttavia, può gradualmente erodere la natura stessa del modo in cui comunichiamo.

In generale, tendiamo a operare un presupposto predefinito che le altre persone siano fondamentalmente sincere e degne di fiducia. La crescita di profili falsi e altri contenuti online artificiali solleva la questione di quanto la loro presenza e la nostra conoscenza su di loro possano alterare questo stato di "truth default", erodendo infine la fiducia sociale.

Cambiare le nostre impostazioni predefinite

La transizione verso un mondo in cui ciò che è reale è indistinguibile da ciò che non lo è potrebbe anche spostare il panorama culturale dall'essere principalmente veritiero all'essere principalmente artificiale e ingannevole.

Se mettiamo regolarmente in discussione la veridicità di ciò che sperimentiamo online, potrebbe essere necessario ridistribuire il nostro sforzo mentale dall'elaborazione dei messaggi stessi all'elaborazione dell'identità del messaggero. In altre parole, l'uso diffuso di contenuti online altamente realistici, ma artificiali, potrebbe richiederci di pensare in modo diverso, in modi che non ci saremmo aspettati.

In psicologia, usiamo un termine chiamato "monitoraggio della realtà" per il modo in cui identifichiamo correttamente se qualcosa proviene dal mondo esterno o dal nostro cervello. Il progresso delle tecnologie in grado di produrre volti, immagini e videochiamate falsi, ma altamente realistici, significa che il monitoraggio della realtà deve essere basato su informazioni diverse dai nostri stessi giudizi. Richiede anche una discussione più ampia sul fatto che l'umanità possa ancora permettersi di non rispettare la verità.

È fondamentale che le persone siano più critiche quando valutano i volti digitali. Ciò può includere l'utilizzo di ricerche di immagini inverse per verificare se le foto sono autentiche, diffidare dei profili dei social media con poche informazioni personali o un gran numero di follower ed essere consapevoli del potenziale della tecnologia deepfake da utilizzare per scopi nefasti.

La prossima frontiera per quest'area dovrebbe essere il miglioramento degli algoritmi per il rilevamento di falsi volti digitali. Questi potrebbero quindi essere incorporati nelle piattaforme dei social media per aiutarci a distinguere il vero dal falso quando si tratta di volti di nuove connessioni.

Circa l'autore

Manos Tsakiris, Professore di Psicologia, Direttore del Centro per la Politica dei Sentimenti, Royal Holloway University of London

Questo articolo è ripubblicato da The Conversation sotto una licenza Creative Commons. Leggi il articolo originale.